在当今数字化浪潮中,Web网站作为信息呈现与交互的核心载体,其结构与功能日益复杂。当面对一个现有网站,无论是出于学习、分析、安全审计,还是逆向工程与二次开发的目的,如何高效、精准地将其“还原”——即理解其技术架构、提取核心逻辑、重构关键功能乃至复现近似版本,已成为网络技术开发领域一个颇具价值的研究课题。本文旨在探讨Web网站还原技术的核心方法、工具链与实践挑战。

一、 网站还原的技术内涵与目标

网站还原并非简单的页面“另存为”,而是一个多层次的逆向工程过程。其目标通常包括:

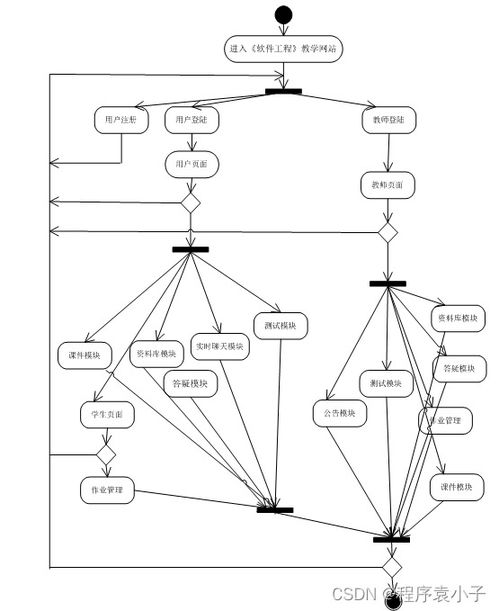

- 结构还原:获取网站的目录结构、HTML骨架、CSS样式与静态资源(如图片、字体)。

- 逻辑还原:解析客户端JavaScript交互逻辑,理解前后端数据交互接口(API)。

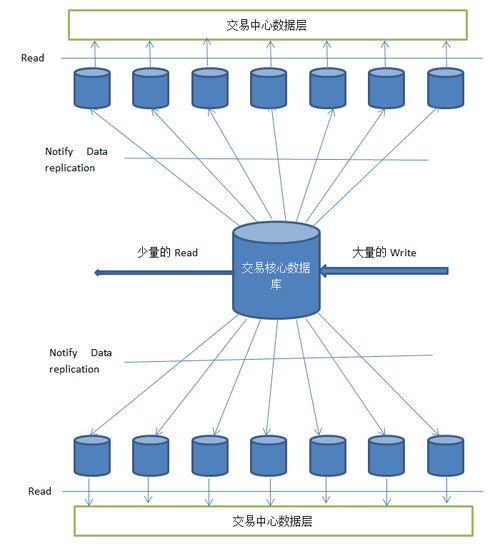

- 数据还原:在合法合规的前提下,分析数据流动模型,理解数据库或状态管理结构。

- 环境模拟:部分或完整地搭建一个可运行、可调试的本地或测试环境。

二、 核心还原技术栈与方法

1. 静态分析与抓取

这是还原的基础。开发者工具(Chrome DevTools等)是首要工具,用于:

- 元素审查:直接查看、复制DOM结构与计算后的CSS。

- 网络监控:捕获所有网络请求(XHR/Fetch),获取API端点、参数格式、响应数据,这是理解网站动态内容的关键。

- 源代码查看:查看格式化后的JavaScript、CSS源代码,并借助“Sources”面板进行调试。

- 资源保存:通过工具或插件批量下载页面关联资源。

2. 动态分析与调试

对于高度混淆、依赖复杂运行时状态的单页应用(SPA),静态分析不足。需要:

- JavaScript调试:设置断点,跟踪函数调用栈,观察变量状态,逐步理解业务逻辑。

- 内存与存储分析:检查LocalStorage、SessionStorage、IndexedDB以及内存中的状态管理(如Vuex、Redux状态树)。

- 反混淆处理:面对经过压缩混淆的代码,可使用格式化工具(如Prettier)和有限的逆向工具提升可读性,或通过动态执行追踪来推断逻辑。

3. 自动化工具与爬虫

对于大规模还原或数据提取,需编写自动化脚本。常用技术包括:

- 无头浏览器:使用Puppeteer、Playwright或Selenium,模拟用户操作,完整渲染页面并执行脚本,可截取状态、触发请求。

- 智能解析库:如BeautifulSoup(Python)用于解析HTML,结合请求库(如Requests)抓取静态内容。

4. 接口分析与模拟

网站的核心业务逻辑往往封装在后端API中。还原时需要:

- 接口文档化:整理捕获的API请求,包括URL、方法(GET/POST)、请求头、参数体、响应格式。

- 认证机制破解:分析Cookie、Token(如JWT)、OAuth等认证流程,以便在模拟环境中复用或模拟认证状态。

- 构建模拟后端:使用Node.js的Express、Python的Flask等框架,根据分析结果快速搭建一个返回模拟数据的API服务器,用于前端独立开发与测试。

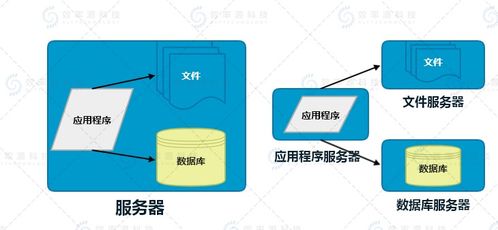

5. 架构推断与重构

综合以上信息,推断网站的技术选型(如React、Vue、Angular框架)和构建工具(Webpack、Vite),尝试在本地初始化类似的项目结构,并将还原出的组件、样式、路由逻辑逐步迁移重构。

三、 开发实践中的挑战与伦理边界

- 技术挑战:代码混淆与压缩、反调试机制、环境检测、数据加密、WebAssembly模块的使用等,都大大增加了还原难度。

- 法律与伦理风险:网站还原研究必须严格限定在合法合规的范围内,如安全研究(需获得授权)、学习交流、对已获授权接口的二次开发。严禁用于盗版、抄袭、侵犯知识产权、未经授权的数据爬取、攻击或商业剽窃。遵守

robots.txt协议和相关法律法规是底线。 - 工程化挑战:还原出的代码往往结构混乱、依赖缺失,将其工程化、模块化,并融入现有开发体系是一项艰巨工作。

四、 正向启示:从还原到创新

对Web网站的深入研究与还原,其最终目的不应止于复制。对于开发者而言,这一过程是绝佳的学习路径:

- 洞察优秀设计:学习顶尖网站的架构设计、性能优化手段与交互细节。

- 理解安全漏洞:通过还原分析,可以更深入地理解常见Web安全漏洞(如XSS、CSRF)的成因与防御方法。

- 推动技术发展:在理解现有技术的基础上,进行改进、创新或开发兼容工具,推动Web技术生态发展。

###

Web网站还原技术是网络技术开发中一项融合了逆向思维、系统分析与工程实践的综合性技能。它像一把手术刀,能够解剖数字产品的肌理,但执刀者必须心怀敬畏,恪守技术伦理。通过科学、严谨的还原研究,开发者不仅能深化对Web技术栈的理解,更能从中汲取灵感,为构建更强大、更安全的下一代Web应用奠定坚实基础。技术视界,既在于前瞻也在于深刻理解当下存在的每一行代码。